Par David Larousserie Publié le 4 janvier 2021

ENQUÊTE Les mesures de lutte contre le nouveau coronavirus ont été prises à la lumière des projections calculées par des spécialistes d’une discipline habituellement discrète, la modélisation, qui s’est soudain retrouvée en première ligne, poussée à ses limites.

Eux aussi ont été en première ligne sur le front de l’épidémie. Pas dans les services hospitaliers, mais dans des bureaux, manipulant des fonctions exponentielles, des échelles logarithmiques ou des paramètres comme le désormais fameux R0 – désignant le taux de reproduction de base du virus. Eux aussi ont vu leurs rangs se diviser entre alarmistes et « rassuristes ». Eux, mais aussi souvent elles, sont les spécialistes de la modélisation, confrérie méconnue, tour à tour oiseaux de mauvais augure, qu’on n’écoute pas, ou oracle qu’on vénère, au gré des flux et reflux du Covid-19 qu’ils décrivent, voire annoncent.

« Enfin, cette discipline commence à intéresser !, apprécie Alain-Jacques Valleron, professeur émérite à Sorbonne Université et membre de l’Académie des sciences. Je suis frappé par le changement entre aujourd’hui et hier. En 1980, lorsque j’installais une petite équipe sur l’épidémiologie des maladies infectieuses, en France, c’était le désert. On s’est débrouillés, et maintenant ça sert dans l’aide à la décision. » Le chercheur peut savourer les progrès.

Toutes les vedettes actuelles du domaine en France, dont Dominique Costagliola, Grand Prix Inserm 2020, sont passées en thèse ou en post-doc dans son unité de l’hôpital Saint-Antoine : Pierre-Yves Böelle (Sorbonne Université), Simon Cauchemez (Pasteur), Vittoria Colizza (Inserm), Pascal Crépey (Ecole des hautes études en santé publique)…

« C’est la première fois que les modélisations ont autant servi en France », constate Lulla Opatowski, professeure à l’université Versailles-Saint-Quentin, formée elle aussi dans cette sphère. « En 2009, au moment de l’épidémie de H1N1, nous avions fait peu de modélisation, en tout cas peu de modélisation réactive », se souvient Pierre-Yves Boëlle, connu pour avoir développé des outils de calcul du fameux R0.

La différence majeure est là. « Répondre à une crise et élaborer un travail académique, c’est très différent !, précise Vittoria Colizza. Dans le premier cas, on ne va pas développer des outils nouveaux, on n’improvise pas. C’est une question de responsabilité : on ne peut pas “tester” des choses pendant une épidémie. » Le temps presse. Alors, ces experts prennent leurs modèles validés dans d’autres situations – comme la grippe, Ebola ou même les maladies nosocomiales d’origine bactérienne… –, et les adaptent aux paramètres de la nouvelle épidémie. « Par rapport à un travail plus académique, nous avons dû faire quelques renoncements, en acceptant de donner des résultats avec de plus grandes marges d’incertitude », précise Laura Temime, professeure au Conservatoire national des arts et métiers.

Scepticisme des débuts

Dans cette course, certains ont même eu un peu de chance. « Nous allions commencer un projet d’évaluation des effets d’une épidémie sur le système hospitalier, et avions déjà récupéré des informations sur les hôpitaux français, leurs localisations, leurs lits, les densités de population autour… Alors on n’a pas perdu de temps lorsqu’il s’est agi de passer au cas réel du Covid », rappelle Pascal Crépey qui, dès le 20 mars 2020, rend disponible sur le site de preprint MedRxiv des scénarios de saturation des établissements région par région. Au début, ses interlocuteurs, à qui il avait fait part, quelques jours avant, de ses conclusions, ne le croyaient pas. Leurs experts maison travaillaient sans modèle, avec des raisonnements simplifiés, et les échanges ont été tendus. « Puis ils nous ont rappelés lorsqu’ils ont vu que les premières observations confirmaient nos anticipations », raconte le chercheur.

Simon Cauchemez aussi était prêt grâce à ses nombreuses connexions internationales. Le 30 janvier 2020, il rendait publics de premiers résultats sur les risques de diffusion du virus dans les autres villes chinoises. Le 5 mars, il entre au conseil scientifique, officiellement installé le 11, et, le 12, il participe à son premier avis, qui prévoit des « centaines de milliers de morts » en l’absence de mesures, et « une deuxième vague (…) dès lors que les mesures seront levées ».

Le week-end suivant, il détaille ses premières estimations aux agences régionales de santé (ARS), basées sur les informations en provenance de Chine et d’Italie. Puis, quelques jours plus tard, avec les toutes nouvelles données hospitalières de la base SI-VIC d’identification et de suivi des victimes d’attentats et de situations sanitaires exceptionnelles, encore très parcellaires, il étaie son modèle dans l’une de ses premières « notes ». Cinquante-cinq autres suivront.

« Le plus dur au début, ce sont les données, car elles font défaut, sont partielles… On part avec des hypothèses sur les paramètres et on les remplace peu à peu par des estimations plus fiables, au fur et à mesure de l’avancée des connaissances sur l’épidémie », explique Vittoria Colizza. « La pire des données, comme je l’explique à mes étudiants, c’est le nombre de cas », rappelle Pascal Crépey, qui, comme ses collègues, utilise les données d’hospitalisations ou les décès, mais qui arrivent avec retard sur la flambée de l’épidémie. Le nombre et le rôle des asymptomatiques posent aussi des problèmes pour bien évaluer les transmissions. Tout comme celui des enfants. Ou l’intervalle de génération, le temps entre deux infections, qui est le double ou le triple de celui de la grippe…

« Jamais nous n’avions testé des mesures d’intervention comme un confinement. Cela a poussé nos modèles aux limites », Vittoria Colizza, directrice de recherche à l’Inserm

« Surtout, jamais nous n’avions testé des mesures d’intervention comme un confinement. Cela a poussé nos modèles aux limites », souligne Vittoria Colizza. « Et comment analyser une épidémie quand ses paramètres changent presque tous les jours ? », complète Simon Cauchemez. Alors c’est la « débrouille ». Les données de téléphonie mobile sont récupérées pour évaluer la baisse du nombre d’interactions entre les Français durant le confinement. Un questionnaire est lancé, SocialCov, auquel répondront plus de 42 000 personnes en avril, pour estimer également ce nombre et la nature des contacts, deux clés pour calibrer les modèles.

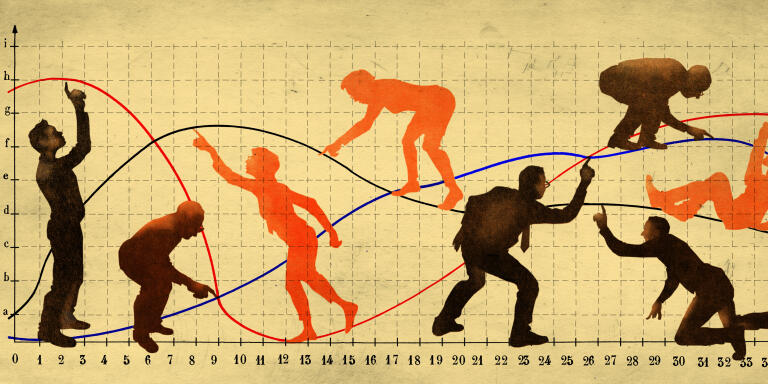

Malgré ces difficultés, « nous assistons au triomphe des modèles… de 1927 ! », plaisante Alain-Jacques Valleron, pour souligner que l’heure n’est pas à la révolution mais à la stabilité. 1927 est en effet l’année de naissance de l’approche épidémiologique dite par « compartiments », où une population entre dans les cases, « sain », « infecté », « guéri » ou « mort », et où des probabilités de passage de l’une à l’autre décrivent la progression d’une maladie. Depuis, le nombre de compartiments a augmenté, en ajoutant des « en réanimation », « asymptomatique », « hospitalisé »… mais la philosophie est restée la même. C’est d’elle que sortent les concepts devenus célèbres de croissance exponentielle, d’immunité de groupe ou de taux de reproduction… « Un modèle aide à représenter un ensemble de petits raisonnements logiques, dont la combinaison tellement compliquée devient impossible à concevoir dans notre tête. Il inclut toute la connaissance à un moment donné, et fournit une analyse de la situation en prenant en compte les incertitudes », résume Lulla Opatowski.

Alain-Jacques Valleron est plus rigoriste quant à sa discipline : « Un modèle, ce n’est pas calculer un taux de reproduction. Cela doit nous aider à découvrir l’inconnu. Par exemple, grâce à cette approche, on a compris, en 1987, ce qui se passait dans l’épidémie de sida en estimant un temps d’incubation très long, de l’ordre de quinze ans. »

« Un modèle, ce n’est pas calculer un taux de reproduction. Cela doit nous aider à découvrir l’inconnu »Alain-Jacques Valleron, professeur d’épidémiologie

Mais si les modélisateurs et modélisatrices ont été en première ligne, ce n’est pas seulement pour l’ancienneté, la rapidité ou la rigueur de leurs analyses. C’est aussi pour leur côté « oracle », bien qu’ils s’en défendent. « Notre job n’est pas de faire des prédictions ! », rappelle Pierre-Yves Böelle, pour tenter de dissiper le malentendu le plus fréquent sur son travail. Les notes de Simon Cauchemez précisent : « La distinction entre “scénario” et “prédiction” est importante. Si l’on considère que les projections associées à un scénario sont des prédictions, cela sous-entend que ces projections vont se réaliser quoi qu’il arrive. Bien entendu, ce n’est pas le cas. Des mesures de contrôle additionnelles ou une meilleure adhésion de la population aux gestes barrières peuvent rapidement et fortement changer la dynamique de l’épidémie, et faire que le scénario ne se réalise pas. » Autrement dit, « nous lançons des alertes pour que la catastrophe n’arrive pas », assume Pascal Crépey. Une pirouette que les détracteurs dénoncent en rappelant les « erreurs » du passé sur la vache folle, ou la grippe H1N1 aux « prévisions » catastrophistes.

Ces critiques glissent sur les modélisateurs qui usent de l’argument souvent entendu que « les modèles ne se trompent pas, ce sont les hypothèses ou les données derrière qui peuvent être incorrectes ». Il est vrai que, concernant la vache folle, la prise en compte de la structure d’âge a fait considérablement baisser le nombre de morts. Et pour la grippe de 2009, la mortalité s’est avérée plus faible que les premières estimations. « Tout n’est pas acquis si on se limite au modèle “général” de 1927 ! », insiste avec humour Alain-Jacques Valleron. « J’ai reçu quelques mails ou courriers d’insultes. On lit le premier, puis après on filtre. On arrête aussi d’écouter ceux qui disent “je ne suis pas épidémiologiste, mais…” », soupire Pierre-Yves Boëlle. Ces spécialistes rappellent aussi que leurs modèles n’ont en rien permis de décider du confinement.

Tous ces experts soudain visibles reconnaissent néanmoins leurs difficultés de communication. « Nous avons dû apprendre à livrer nos résultats au grand public, mais aussi aux décideurs, notamment en indiquant les incertitudes, les fourchettes, en parlant de “scénarios” plutôt que de “prédictions”….», résume Laura Temime. « Ce n’est pas simple car ce qui est lu n’est pas toujours ce qui est écrit », se souvient Pierre-Yves Boëlle, qui rappelle que certains ont accusé un de ses articles de stigmatiser les personnes âgées, alors qu’il s’agissait d’étudier l’effet de la réduction des contacts dans cette tranche d’âge. « L’un des problèmes est que si les spécialistes ne prennent pas la place, d’autres, moins experts, la prennent, témoigne Pascal Crépey. C’est assez gênant de se retrouver le porte-parole d’une communauté. La médiatisation apporte une légitimation qui n’est pas dans nos habitudes académiques. »

Travail de coordination

Pendant que ces spécialistes de première ligne font tourner leurs ordinateurs, acceptent la lumière médiatique, essuient les critiques et alimentent les conseillers des décideurs, un second cercle s’est très vite agité. « On piaffait d’impatience ! », témoigne Pierre-Louis Lions, mathématicien médaillé Fields, pour qui une croissance exponentielle n’a pas de secret et qui très tôt voit la catastrophe arriver. « A partir de février, nous avons commencé à recevoir des propositions de modèles, des questions sur des articles publiés, des offres d’assistance… émanant de chercheurs dont l’épidémiologie n’était pas le cœur de métier, mais très compétents, indique Jean-Stéphane Dhersin, mathématicien, directeur adjoint de l’Institut national des sciences mathématiques et de leurs interactions du CNRS. Nous savions que les spécialistes de la modélisation des épidémies étaient sous l’eau et engagés dans des modélisations pour aider à la décision. Alors naît l’idée de coordonner l’ensemble de ces volontés pour faire autre chose. Le 31 mars, le réseau Modcov19 était lancé. »

En une semaine, ce sont 150 personnes qui le rejoignent pour réaliser une veille bibliographique, proposer des exposés, réunir des groupes de travail… La même initiative au Royaume-Uni, sous l’égide de la Royal Society, a motivé 1 800 volontaires, indice d’une culture de la modélisation en épidémiologie plus diffusée outre-Manche, qui a inventé la discipline.

Très vite, une idée jaillit dans ce réseau. « Les premiers modèles, dont celui de l’Imperial College de Londres, manquaient de ce que l’on appelle l’“analyse de sensibilité”, c’est-à-dire l’estimation de l’influence de chaque paramètre dans le résultat. Certains facteurs comptent plus que d’autres, et il est donc important d’en réduire l’incertitude. Or, justement, on réalise que la part des asymptomatiques est l’un de ces facteurs-clés. On a donc proposé de réaliser un échantillonnage aléatoire en Ile-de-France pour connaître la prévalence de la maladie », indique Josselin Garnier, mathématicien, professeur à l’Ecole polytechnique au Centre de mathématiques appliquées (CMAP). Un noyau d’une dizaine de personnes aux compétences variées est motivé pour mener l’expérience. La Ville de Paris soutient. « Et puis ça s’est complexifié. Je ne sais pas ce qu’il s’est passé. Pas vraiment un mur, mais ça s’est embourbé. Et ça ne s’est pas fait », tranche Josselin Garnier, déçu mais pas amer.

Voir dans le brouillard des données

Une collègue aura eu « plus » de chance. Saisissant l’idée au bond, Anne Gégout-Petit et Pierre Vallois, professeurs en probabilités et statistiques à l’université de Lorraine, décident de lancer la même chose dans la métropole de Nancy. Début avril, les premiers contacts sont pris, et l’expérience est réalisée en juillet sur 2 000 personnes, mais… toujours pas de résultats communiqués au 3 janvier.

« A la réunion hebdomadaire de mon équipe, le 12 mars, je fais un exposé sur l’épidémie, en m’étonnant de ne pas voir de résultats de nos collègues modélisateurs, alors qu’en Angleterre il y a déjà des publications. J’explique qu’on pourrait s’y mettre », rappelle Samuel Alizon, directeur de recherche au CNRS au Laboratoire maladies infectieuses et vecteurs : écologie, génétique, évolution et contrôle de Montpellier. Ce spécialiste de biologie de l’évolution ne déclenche pas l’enthousiasme car le sentiment général est que « tout le monde va le faire ».

Finalement, son groupe identifie plusieurs « niches » et une cible, la frange la plus curieuse du grand public, qui les hissent au rang d’interlocuteurs crédibles dans le cercle de la modélisation de l’épidémie. Ils sont les premiers à analyser les séquences génétiques virales nationales et à faire le lien avec les propriétés de l’épidémie. Ils calculent les fameux taux de reproduction. Mettent en ligne des projections avec plusieurs paramètres ajustables… Treize « rapports » et deux logiciels sont mis en ligne. « Finalement, c’était original et pas si mauvais ! », s’amuse le chercheur.

Un autre mathématicien du CMAP, Marc Lavielle, s’est distingué également par une approche originale. Lui, comme d’autres, est capable de « voir » dans le brouillard des données. Depuis septembre, cet habitué des développements informatiques et des logiciels a mis en ligne une sorte de thermomètre de l’épidémie en France, qui extrait les accélérations et décélérations successives de la pandémie. C’est une approche classique en mathématiques ou physique. Au lieu de modéliser les phénomènes, on modélise les données elles-mêmes, c’est-à-dire qu’on essaie de trouver la meilleure fonction mathématique qui reproduit l’évolution observée. Autrement dit, on cherche à savoir si une croissance est exponentielle, plutôt que d’expliquer pourquoi elle le serait, comme le font les modèles par compartiment.

Et, en l’occurrence, le spécialiste découvre que c’est « super-exponentiel » en octobre ! Le coefficient exponentiel change au cours du temps… Il a même vu très tôt le ralentissement de la décrue après le deuxième pic et la probable réaugmentation actuelle… « Il ne faut pas se contenter de regarder si ça monte (on est inquiet) ou si ça descend (on est rassuré). Il faut surtout regarder comment évoluent ces variations dans le temps », résume le chercheur.

Une autre communauté est montée au créneau pour défendre une troisième voie, ni compartiments ni modélisation des données. « Début mars, nous avons lancé une initiative pour répondre à des défis posés par l’épidémie. D’un noyau de cinq personnes, géographes, informaticiens, matheux, on est vite passés à trente », résume Arnaud Banos, géographe, directeur de recherche au CNRS, à l’origine de ce collectif baptisé CoVprehension. Leur spécialité est la simulation multi-agents, c’est-à-dire la reproduction in silico de mini-sociétés humaines, représentées par des individus qui se déplacent, interagissent, se confinent, s’éloignent et se passent ou non des virus… L’approche est donc différente de celle des compartiments qui ont emporté la mise. Pourtant, c’est une telle technique qui fait parler d’elle en premier. Les conclusions de l’Imperial College de Londres et de Neil Ferguson du 16 mars sont tirées de telles simulations, développées et validées auparavant sur la grippe.

« En fait, ce gros modèle très détaillé donne les mêmes résultats que les approches par compartiment, qui ont moins de paramètres », note Samuel Alizon. L’équipe de Ferguson elle-même rebasculera très vite sur les « compartiments ». « Ces méthodes sont plus compliquées en pratique à mettre en œuvre et sont donc moins opérationnelles, notamment en temps de crise », rappelle Alain-Jacques Valleron. « Les simulations multi-agents mettent mieux en évidence la variabilité des phénomènes », plaide Arnaud Banos, qui constate que les deux approches sont moins séparées qu’elles n’ont été.

Elles sont très efficaces pour la pédagogie, comme le montrent les vingt défis visibles sur le site de CoVprehension, assortis d’autant de simulations interactives. Au lieu d’équations différentielles, des boules se déplacent, se touchent, changent de couleur. On saisit mieux le rôle de la distanciation physique, du confinement… Mieux, on perçoit l’importance du réseau social d’interactions, des superpropagateurs… Un livre de deux membres du collectif, Juliette Rouchier et Victorien Barbet, La Diffusion de la Covid-19 (Editions Matériologiques, 2020), résume bien les apports pédagogiques mais aussi scientifiques de ces méthodes. « L’approche qualitative de ces modèles aurait été particulièrement adaptée en complément des approches quantitatives. On aurait aussi pu s’en servir pour affiner par essai-erreur in silico les définitions précises des politiques publiques qu’on souhaitait mettre en place. Tout cela plaide pour une plus grande diversité des approches et de la recherche plus collective », estime Juliette Rouchier.

Premier cercle, deuxième cercle, on peut même y ajouter un troisième, en comptant cette foule de scientifiques de bonne volonté qui ont voulu apporter leur pierre à l’édifice. Ce physicien, par exemple, qui est passé aux échelles logarithmiques pour montrer les proximités des croissances chinoises, italiennes, françaises et qui voulait alerter sur les sommets catastrophiques à venir. Ou cet astrophysicien qui lui aussi à partir des mêmes données livre des bulletins météo inquiétants. « J’ai reçu pas mal de choses plus ou moins loufoques, ou des messages hebdomadaires qui se contentaient de prolonger les courbes… Dans le lot, forcément, il y a eu des choses justes », se rappelle Jean-Stéphane Dhersin, qui met en avant le caractère « altruiste » des mathématiciens et « l’expérience humaine agréable » qu’il a vécue.

« C’est ce que j’appelle la recherche hors les murs, participative. Ça a été extraordinaire sur le Covid. Certes avec du mauvais, mais aussi du bon ! », apprécie Alain-Jacques Valleron. « On ne devient pas spécialiste en quelques semaines », tempère cependant Pierre-Yves Boëlle.

Il y a aussi eu ce retour de balancier, qui a fait brutalement passer de l’absence de modèles au trop-plein de chiffres, et qui a conduit à publiciser des taux de reproduction avec deux chiffres après la virgule, sans aucun sens.

Il est encore trop tôt pour savoir si le paysage national restera identique ou se rapprochera des systèmes britanniques ou américains, qui ont une culture et une communauté plus importante sur ce sujet. « Améliorer l’articulation entre modélisation et aide à la décision était en cours en France, souligne Simon Cauchemez. Le Covid-19 a donné un coup d’accélérateur. » « On doit poursuivre la réflexion sur la meilleure manière de faire », appuie Pascal Crépey. Pour l’instant, Santé publique France (SPF) avait choisi de ne pas avoir une véritable équipe de modélisateurs, préférant entretenir des collaborations avec le monde académique afin de rester au « sommet des connaissances », indique Daniel Lévy-Brühl, responsable de l’unité des infections respiratoires de SPF, qui précise que la modélisation nourrissait déjà les décisions de l’organisme, par exemple sur les stratégies vaccinales. Le réseau Modcov19 est en tout cas pérennisé pour quatre ans, prêt à mieux répondre aux besoins.

En attendant, chacun tire des satisfactions personnelles, avec notamment des publications dans des revues prestigieuses. « J’ai trouvé avec cette pandémie de nouveaux collaborateurs et de nouveaux projets, comme la simulation de l’occupation des lits d’hôpitaux », témoigne Anne Gégout-Petit. « Cela fera d’excellents exemples pour mon cours d’analyse de sensibilité », note Josselin Garnier. Mais pour beaucoup, toujours sous pression et qui semblent avoir perdu la notion du temps, un souhait est prioritaire, « vivement que ça s’arrête ! ».

Aucun commentaire:

Enregistrer un commentaire