Par Laure Belot Publié le 20 septembre 2022

Le visionnage de courtes vidéos décrivant les procédés rhétoriques des infox pourrait limiter la diffusion de celles-ci sur les réseaux sociaux, suggère une expérience menée en laboratoire et en vie réelle.

Le 31 août, l’astronaute Thomas Pesquet a dû longuement expliquer sur Twitter que « bien sûr que oui, l’humain est allé sur la Lune pendant les missions Apollo », après que ses propos ont été déformés par des négateurs de la conquête par l’homme de notre satellite.

Enième illustration du fait que la désinformation en ligne continue d’être un problème sociétal majeur. Et ce, malgré la multiplication dans les médias de services de debunkers [de l’anglais debunk, « discréditer »], des journalistes qui, à l’image des Décodeurs du Monde, cherchent à vérifier des affirmations suspectées d’être fallacieuses. Comment trouver d’autres parades à ces « fake news » qui massivement se répandent sur les réseaux sociaux et, par ricochet, dans la société et les foyers ?

Une équipe internationale de chercheurs en psychologie des universités de Cambridge, Bristol (Royaume-Uni) et Perth (Australie) a réalisé une expérience inédite par son ampleur, à l’aide d’un partenariat avec le laboratoire Jigsaw (Google, Etats-Unis). Par vidéos interposées, ils ont « psychologiquement inoculé », expliquent-ils, de fausses nouvelles à faible dose à des internautes afin de stimuler, un peu à l’image d’un vaccin, l’immunité de ceux-ci envers la désinformation, et de leur apprendre à faire le tri entre le bon grain et l’ivraie. Les résultats obtenus, plutôt encourageants, ont été publiés dans Sciences Advances le 24 août.

« Nous avons eu l’idée par “inoculation” d’immuniser les gens contre les techniques de manipulation courantes en créant, en février 2018, le jeu des mauvaises nouvelles », explique l’auteur principal de la publication, Jon Roozenbeek, de l’université de Cambridge. L’idée de ces vidéos s’inscrit dans le prolongement de ce premier travail. »

Etude en labo et en « vie réelle »

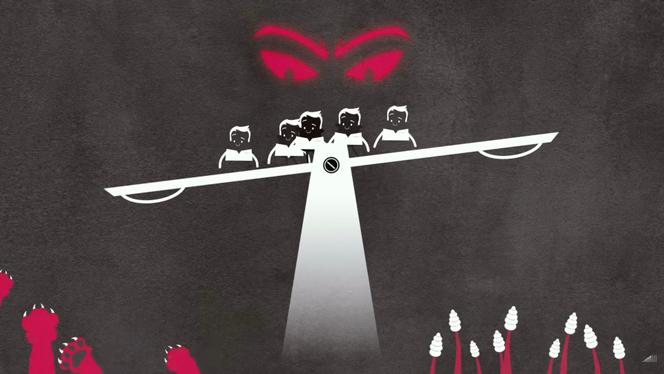

Pour lancer cette nouvelle étude, les chercheurs ont imaginé cinq courts films de quatre-vingt-dix secondes qui présentent des techniques de manipulations fréquemment utilisées dans des pratiques de désinformation : le langage émotionnellement manipulateur, l’incohérence, les faux dilemmes, la technique du bouc émissaire et les attaques ad hominem.

Chacune des vidéos s’articule de la même façon : un premier message trompeur – par exemple dans le cas du langage manipulateur, une petite fille triste avec une voix off appelant à regarder la suite même si cela va faire pleurer –, puis vient un film d’animation pour décrypter la manipulation. « Quand le message est annoncé comme générant des émotions négatives telles que la peur, la colère ou le mépris, cela donne envie de regarder le reste de la vidéo », apprend-on. Enfin, un court exercice pratique conclut le film afin de vérifier que la technique de manipulation a été bien assimilée.

A l’aide de ce matériel visuel, deux grandes études ont été conduites : une « en laboratoire » auprès de 6 000 personnes et une dans la « vie réelle », auprès de 22 000 usagers de YouTube. Pour la première expérience, les 6 000 personnes en ligne ont été divisées en deux groupes, A et B, égaux en taille. Les « A » ont regardé les vidéos décrites ci-dessus, les « B » des vidéos neutres. Puis les scientifiques ont proposé à ces deux groupes dix messages non politiques sur les médias sociaux : cinq utilisant des techniques délibérément manipulatrices et cinq messages neutres.

Tous les participants ont ensuite été invités à classer leurs niveaux de confiance dans ces dix informations, le degré de manipulation qu’ils ressentaient et la probabilité qu’ils auraient de partager ces messages en ligne. Résultat, les membres du groupe A ont été capables d’identifier 1,6 fois plus que les « B » des messages comportant un langage émotionnellement manipulateur, 1,95 fois plus les messages présentant de faux dilemmes et 2,14 fois plus les messages incohérents. La même expérience a ensuite été menée en ligne aux Etats-Unis et sur quinze jours sur deux groupes d’usagers de YouTube (11 000 « A » et 11 000 « B »), avec des résultats similaires.

« Ces vidéos permettent d’améliorer la reconnaissance des techniques de manipulation, commente Jon Roozenbeek. Elles augmentent la capacité des gens à discerner le contenu digne de confiance de celui qui ne l’est pas, et améliorent la qualité de leurs décisions de partage. » Le chercheur se dit particulièrement satisfait « que ces résultats se soient maintenus sur YouTube, alors que les gens pouvaient sauter les vidéos, couper le son, changer d’onglet et trouver d’autres moyens de ne pas y prêter attention ».

L’équipe scientifique estime que cette solution pourrait être plus efficace à grande échelle, pour lutter contre le déluge de désinformation, que la vérification des faits au cas par cas après la diffusion de chaque contre-vérité.

Le rôle des algorithmes

Depuis l’université de Fribourg, en Suisse, Sebastian Dieguez, chercheur en psychologie cognitive, s’interroge sur le principe même de l’inoculation psychologique. « Le grief principal que j’ai contre cette méthode est qu’elle est similaire dans la forme à celle utilisée pour communiquer dans les milieux complotistes. » Il est intéressant, poursuit-il « que cette recherche combine une étude de laboratoire et une autre avec des usagers de YouTube, cela permet de documenter ces phénomènes de désinformation dans la vie réelle. Mais la limite est que l’on se retrouve dans des situations assez artificielles, avec des personnes prévenues, qui doivent jauger des messages assez inoffensifs, ni politiques ni clivants. » Pour le neuroscientifique, « même s’il est utile de sensibiliser les gens à des manœuvres rhétoriques pour aider à distinguer des sources fiables des autres, cela ne va pas changer les gens qui ont des avis clivants sur certains sujets ».

Et que dire du rôle des algorithmes des grandes plates-formes qui diffusent sur les écrans ces fausses informations et, de fait, entretiennent la désinformation ? Une étude récente réalisée par des chercheurs du département d’affaires publiques de l’université de New York (Journal of Online Trust and Safety du 1er septembre)affirme que l’algorithme de YouTube est plus susceptible de diriger les vidéos évoquant une fraude électorale vers des utilisateurs déjà sceptiques quant à la légitimité de l’élection présidentielle américaine de 2020. Ce problème d’algorithme « est le nerf de la guerre », commente Sebastian Dieguez. « Il faut essayer de normer et mettre un peu d’hygiène dans ces environnements difficilement contrôlables, chez ces acteurs tels les GAFA qui ne répondent pas vraiment aux injonctions des pouvoirs publics. »

La solution à la désinformation ne se fera pas seulement par une prise de conscience individuelle, réagit quant à lui Jon Roozenbeek. « Les approches telles que nos vidéos sont utiles et peuvent être efficaces, mais elles ne sont pas suffisantes. Des approches systémiques notamment au niveau des algorithmes de recommandation, sont également nécessaires », reconnaît le chercheur qui, avec son équipe, s’est déjà attelé à une nouvelle étape : poursuivre l’expérience dans d’autres pays et tenter de mesurer combien de temps tient l’effet d’« inoculation ».

Aucun commentaire:

Enregistrer un commentaire