Par Cécile Ducourtieux Publié le 4 octobre 2022

Les parents de Molly Russell, jeune adolescente qui s’est suicidée en 2017, ont obtenu que les réseaux sociaux auxquels leur fille était inscrite soient reconnus responsables de sa mort. En cause, son exposition à des contenus ciblés jugés inappropriés et dangereux.

Elle s’appelait Molly Russell, elle avait 14 ans, passait beaucoup de temps sur les réseaux sociaux, comme nombre de jeunes gens de son âge : Pinterest, Instagram, WhatsApp… Un soir de novembre 2017, cette habitante de Harrow, banlieue agréable du nord-ouest de Londres, s’est suicidée dans sa chambre, après un repas sans histoire en famille. Depuis ce drame, ses parents, Ian et Janet, ont fait campagne sans relâche pour faire reconnaître la responsabilité des géants d’Internet dans la disparition de leur fille.

Vendredi 30 septembre, ils ont obtenu gain de cause : à l’issue de quinze jours d’audience, Andrew Walker, le coroner de la cour des coroners du nord de Londres, une instance indépendante de la police et de la justice, chargée d’établir la cause et les circonstances d’un décès, a conclu que « les effets négatifs des contenus en ligne » avaient « contribué » à la mort de Molly. Ces contenus « n’étaient pas sûrs » et « n’auraient pas dû être accessibles pour un enfant », a-t-il ajouté. C’est la première fois au Royaume-Uni que la responsabilité des géants d’Internet est engagée dans la mort d’un enfant.

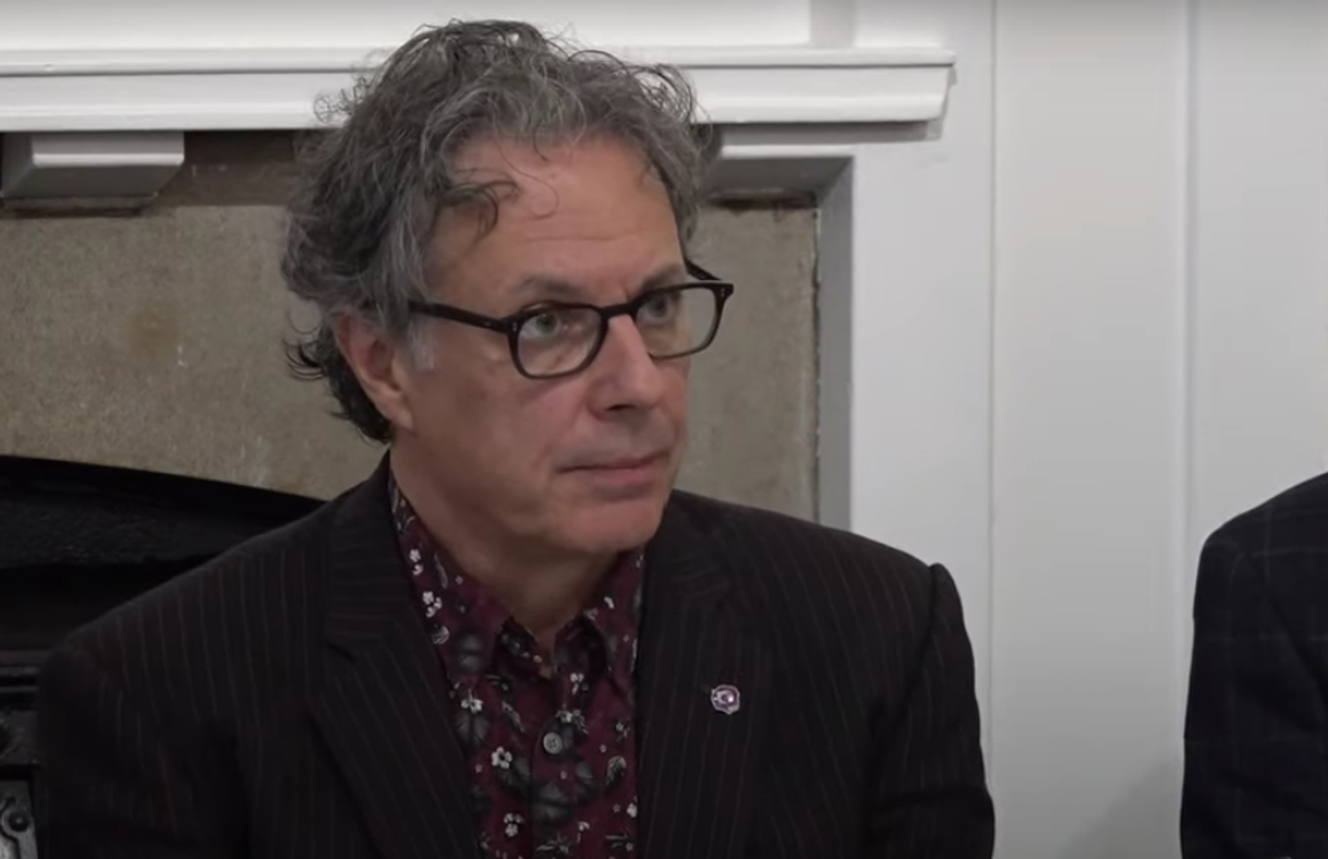

S’adressant particulièrement à Meta, propriétaire d’Instagram et de Facebook, Ian Russell, le père de Molly, a déclaré à la clôture de l’enquête : « Il est temps de protéger nos jeunes gens. Il est temps que la culture toxique au cœur des plus grandes plates-formes mondiales de réseaux sociaux change et qu’ils ne puissent plus prioriser leurs profits aux dépens des souffrances des jeunes. » Ce père Courage qui, pendant cinq ans, n’a pas lâché prise face aux géants d’Internet, a aussi encouragé Mark Zuckerberg, le PDG de Meta, à écouter « les gens qui utilisent ses plates-formes, à écouter les conclusions du coroner et à agir en conséquence ».

Une adolescente sous e-influence négative

Molly était une jeune fille normale, elle avait plein de projets d’avenir, ont souvent raconté ses parents. Elle a changé de comportement environ un an avant sa mort : elle était davantage renfermée, passait plus de temps dans sa chambre, mais ils l’ont d’abord mis sur le compte de l’adolescence ; alors que leur fille s’enfonçait dans une spirale dépressive tandis qu’elle consultait de grandes quantités de contenus négatifs en ligne. Selon l’enquête du coroner, la jeune fille a été bombardée de contenus liés à la dépression, aux mutilations ou au suicide : sur 16 300 pages vues dans les six mois précédant sa mort, elle en avait consulté 2 100 dont 138 vidéos parlant de suicide ou de mutilations.

En cause, ces algorithmes exploitant les données de connexion des internautes pour leur proposer des contenus ciblés. Ainsi, trente-quatre comptes Instagram avaient été recommandés à Molly qui étaient « tristes ou liés à la dépression ». Molly a même reçu un message de Pinterest lui recommandant « 10 pins [points d’intérêt] déprimants que tu pourrais aimer ». Pour l’avocat Oliver Sanders, représentant la famille Russell, « Instagram a littéralement donné des idées à Molly ».

Il a fallu des années à Ian Russell pour obtenir l’accès aux profils en ligne de sa fille, les Big Tech faisant de la résistance. WhatsApp avait supprimé le compte de Molly et il y a eu une longue bataille légale pour avoir accès aux contenus qu’elle avait consultés sur Instagram. Obligée de comparaître devant le coroner, Elizabeth Lagone, la responsable des « politiques de bien-être et de santé » chez Meta, a défendu le caractère approprié de certains contenus consultés par Molly. Jud Hoffman, le responsable des opérations du site de partage de photos Pinterest, a en revanche « profondément regretté » que l’adolescente ait pu être exposée à de tels contenus, avouant qu’il ne laisserait pas ses propres enfants les visionner.

« Nous devons à la famille de Molly de faire tout ce qui est en notre pouvoir pour éviter que [ce drame] se répète. »

Les révélations en 2021 de la lanceuse d’alerte Frances Haugen ont jeté une lumière crue sur les pratiques de Facebook. Cette ingénieure travaillant pour le réseau social a fait passer des milliers de documents internes à la Securities and Exchange Commission américaine et au Wall Street Journal, parmi lesquels certains pointant des contenus potentiellement dangereux pour les adolescentes sur Instagram. « Nous aggravons les problèmes d’images corporelles pour une adolescente sur trois », selon un document interne datant de 2019.

Depuis la mort de Molly, les sociétés de l’Internet ont évolué et font davantage la chasse aux contenus dangereux pour la santé mentale des jeunes. Mais tous ne sont pas retirés – ni retirés rapidement. Le coroner Walker a ainsi réclamé des procédés plus efficaces de vérification de l’âge des utilisateurs des réseaux. Les conclusions de son enquête aideront peut-être à l’adoption du projet de loi Online Safety Bill, visant à mieux contrôler les contenus en ligne, en discussion depuis des mois au Parlement britannique.

Liz Truss, la nouvelle première ministre, a suspendu son examen, estimant que le contrôle des contenus « à caractère légal mais dangereux » menace la liberté de parole. Mais il paraît désormais difficile, après la publicité faite au cas « Russell », de trop affaiblir le texte de loi. Pour Michelle Donelan, la ministre de la culture de Mme Truss, « nous devons à la famille de Molly de faire tout ce qui est en notre pouvoir pour éviter que [ce drame] se répète ».

Le Online Safety Bill britannique oblige les géants d’Internet à un « devoir de vigilance » : à eux de protéger les enfants des contenus potentiellement dangereux. Ils doivent évaluer les dangers que présentent leurs plates-formes et mettre en place les moyens adéquats pour en éloigner les enfants. L’Ofcom, le régulateur national des télécommunications, est censé évaluer ces efforts.

Aucun commentaire:

Enregistrer un commentaire